Die neue Google Search Console bietet nicht einfach nur ein neues Design, sondern viele neue Funktionen, die ganz anders sind als bei der alten Version. Die Umstellung wird nicht einfach – verspricht aber viele neue Einblicke in Crawling und Indexierung.

Die Google Search Console ist nach wie vor eines der wichtigsten SEO-Tools – und auch die einzige Quelle vieler Daten. Allerdings ist die Google Search Console (ehemals Google Webmaster Tools) auch schon etwas in die Jahre gekommen.

Seit dem 8. Januar 2018 (siehe webmasters.googleblog.com/2018/01/introducing-new-search-console.html) gibt es nun offiziell eine neue Version, die 2017 schon in einer geschlossenen Beta-Phase getestet wurde. Die neue Search Console unterscheidet sich in Design und Struktur deutlich von der alten Version. Allerdings sind derzeit noch nicht alle Funktionen des alten Tools in der neuen Variante verfügbar. Laut Google wird es durchaus noch bis Ende 2018 dauern, bis der Stand vergleichbar ist. Bis dahin sollen beide Versionen parallel genutzt werden können. Um jeweils zur anderen Variante zu wechseln, klickt man einfach auf „Jetzt die neue Search Console testen“ (alt) bzw. „zur alten Version wechseln“ (neu).

Viele wichtige Funktionen wie „Abruf wie durch Googlebot“ fehlen noch, sodass ein ausschließlicher Wechsel zur neuen Version ohnehin noch nicht möglich ist. Durch den geringen Funktionsumfang wirkt die neue Version noch relativ leer. Insgesamt wurden Funktionen nicht einfach nur verschoben oder umbenannt, sondern ganz anders umgesetzt. Einzelne Reports wie „Crawling-Fehler“ aus der alten Search Console gibt es nicht mehr; diese wurden in den großen Report „Indexabdeckung“ integriert.

Leistung

Ein wichtiger Punkt ist sicherlich die Funktion „Leistung“, die der vorherigen „Suchanalyse“ entspricht. Hier findet sich auch die wichtigste Neuerung: Statt der stets monierten 90 Tage gibt es nun Daten für die letzten 16 Monate. Somit ist es jetzt endlich möglich, Saisonalitäten abzudecken, indem man z. B. die letzten 90 Tage mit denen aus dem Vorjahr vergleichen kann. Hierfür wurden auch schon Filter vordefiniert, z. B. „Letzte 3 Monate mit dem entsprechenden Zeitraum im Vorjahr vergleichen“, was sehr praktisch ist. Man kann auch beliebige Zeiträume miteinander vergleichen. Das ging vorher auch schon, war aber bei 90 Tagen nur wenig sinnvoll. Mit der neuen Datenfülle haben die Vergleichsfunktionen somit an Bedeutung hinzugewonnen.

Geblieben ist allerdings ein bekannter Flaschenhals. Es gibt nach wie vor nur 1.000 Suchanfragen oder Seiten. Mehr Informationen sind bestenfalls über Tricks erreichbar (mehrere Propertys anlegen und diese später kombinieren). Mehr Dimensionen gibt es auch nicht: Mit Klicks, Impressionen, CTR und Position ist man hier aber auch sehr gut bedient.

Interessant ist, dass derzeit noch ein wichtiger Filter aus der alten Suchanalyse fehlt. Über den Filter „Darstellung in der Suche“ konnten gezielt „Ergebnisse mit Rich Media“ gesucht werden. So war es z. B. möglich, Rich Snippets zu finden bzw. die Frage zu beantworten, für welche Seiten und Suchanfragen man über Rich Snippets verfügt.

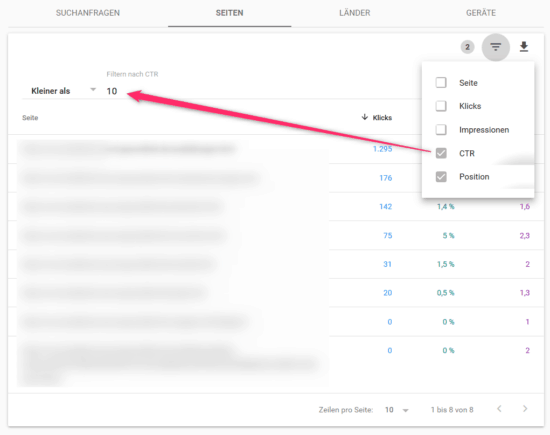

Praktisch ist auch der neue Filter in der Suchanalyse (siehe Abbildung 1). Gefiltert werden kann nach allen Metriken (Suchanfrage, Seite, Klicks, Impressionen, CTR, Position) – und das in beliebiger Kombination. So kann man schnell Seiten finden, die ein hohes Ranking, aber eine niedrige Klickrate haben.

Indexabdeckung

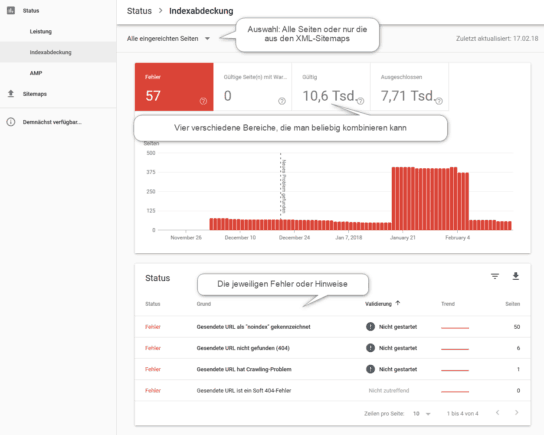

Ebenfalls spannend ist der neue Report namens „Indexabdeckung“. Zugleich findet sich hier auch die größte Änderung, da viele alte Reports in einem neuen Report zusammenkommen. Außerdem gibt es jetzt Einblicke in den Crawling- und Indexierungsprozess, die es so vorher gar nicht gab.

Die Indexabdeckung ist leider etwas unglücklich benannt, weil es dort nicht nur um den Index geht, sondern auch um das Crawling. Der Report beantwortet prinzipiell aber eher die Frage nach dem Index: Welche Seiten sind im Index? Und welche nicht?

Insgesamt funktioniert der neue Report am besten im Zusammenspiel mit XML-Sitemaps. Das ist hier also eine wichtige Grundvoraussetzung. Unternehmen sollten sicherstellen, dass diese stets aktuell und auch korrekt sind. In der Indexabdeckung kann oben immer zwischen „eingereichte Seiten“ (alle Seiten, die in den XML-Sitemaps genannt werden) und „alle bekannten Seiten“ (alle Seiten, die Google irgendwie gefunden hat) gefiltert werden.

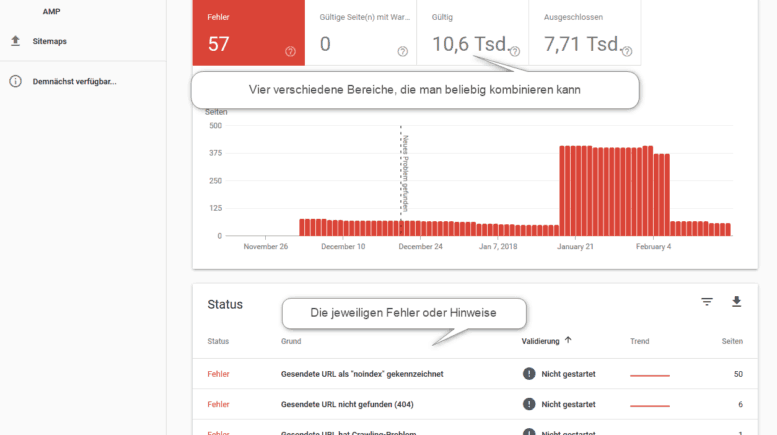

Die Indexabdeckung hat oben immer vier Bereiche, die man auswählen und miteinander kombinieren kann (auch wenn das nicht unbedingt intuitiv umgesetzt ist). Nach der Auswahl von z. B. „Gültig“ werden dann im unteren Bereich die unterschiedlichen Fehler- oder Hinweis-Kategorien angezeigt (siehe Abbildung 2). Wenn man auf eine solche Kategorie klickt, erhält man die jeweiligen URLs – maximal aber nur 1.000 Stück. In der Regel reicht das natürlich vollkommen aus, um systematische Fehler zu finden. Nur bei sehr großen Websites wären mehr Daten sinnvoll – aber auch dann könnte man das Daten-Limit überschreiten, indem man mehrere Propertys anlegt und die Daten dann miteinander kombiniert.

Spannend sind die unterschiedlichen Fehler- und Hinweis-Kategorien auf jeden Fall, weil sie deutlich mehr Fälle als in der alten Google Search Console abdecken, z. B.

- Indexiert, nicht in Sitemap gesendet (Seite wurde indexiert, ist in der XML-Sitemap aber nicht zu finden)

- Seite wegen rechtlicher Beschwerde entfernt

- Duplizierte Nicht-HTML-Seite (z. B. PDF-Datei und HTML-Datei haben denselben Inhalt, aber kein Canonical Tag)

- Duplikat, aber ohne kanonisches Tag (die Seite ist eine Dublette, verfügt aber über kein Canonical Tag)

- …

Alle unterschiedlichen Fälle kann man hier nachlesen: support.google.com/webmasters/answer/7440203. Es ist zu empfehlen, diese unterschiedlichen Fälle und deren Lösungswege zu kennen. So klingen z. B. die beiden Kategorien „Gecrawlt – derzeit nicht indexiert“ und „Gefunden – zurzeit nicht indexiert“ sehr ähnlich. Damit sind aber gänzlich andere Fälle gemeint.

Auch hier gilt wieder: Das Mehr an Informationen sorgt nicht unbedingt dafür, dass man daraus auch Kapital schlagen kann. Das liegt natürlich zum einen am Kenntnisstand des jeweiligen Nutzers, aber auch daran, dass die Behebung vieler Fehler nicht zu einer Ranking-Verbesserung führen wird. So sollte man hier vorsichtig sein und nicht angesichts der vielen Hinweise, die nahezu jede Website generiert, in blinden Aktionismus verfallen. Einige Hinweise sind ernst zu nehmen, einige sind aber auch eher akademischer Natur. Google hat viele Aspekte auch bislang schon gut hinter den Kulissen geregelt. Nur weil man jetzt mehr Einsicht bekommt, bedeutet das nicht, dass Google hier auch oft mit suboptimalen Websites perfekt klarkommt.

Dennoch: Für eine technische Analyse der Website ist der neue Report „Indexabdeckung“ Gold wert. Die Beschränkung auf 1.000 Ergebnisse ist dabei nur eine kleine Einschränkung, denn systematische Fehler sollten natürlich trotzdem sichtbar werden.

Prozessorientiert

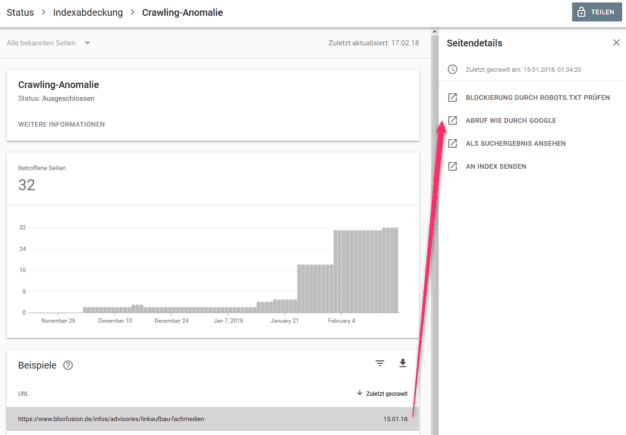

Vor allem bei der „Indexabdeckung“ sieht man: Die Google Search Console ist prozessorientierter geworden. Man kann Probleme entdecken, tiefere Daten abrufen und dann in der Regel auch direkt damit etwas machen. Wer wie in Abbildung 3 eine URL anklickt, erhält rechts direkt relevante Aktionen angezeigt – was extrem praktisch ist.

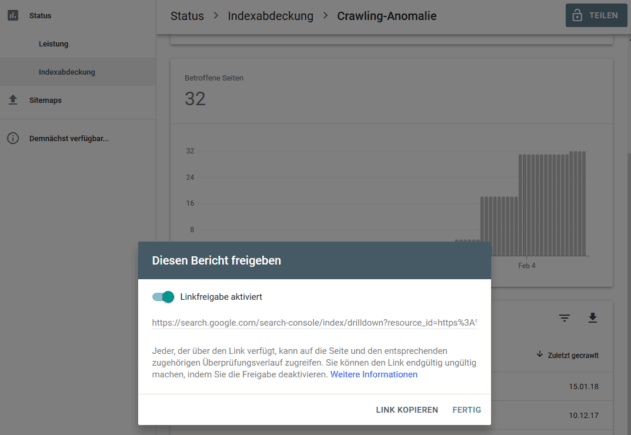

Ebenfalls sinnvoll kann die „Teilen“-Funktion sein (siehe Abbildung 4). So kann man einen bestimmten Report bzw. den Zugriff darauf schnell per E-Mail verschicken, ohne dass der Empfänger einen Zugriff auf das Search-Console-Konto haben muss. Komplizierte Nutzerfreigaben braucht es also nicht – vorausgesetzt wird nur, dass der Empfänger auch ein Google-Konto hat.

Noch mehr Reports

Wie gesagt, befindet sich die Google Search Console noch in einem unfertigen Zustand. Wichtige Reports und Einstellungen fehlen noch.

Interessant ist aber, dass mit „AMP“ und „Job Posting“ schon zwei Reports verfügbar sind, die für die Mehrheit der Nutzer gar nicht so wichtig sind. Hier zeigt sich aber, welche Themen Google derzeit besetzen möchte. Es wäre natürlich fatal, Website-Betreiber zu motivieren, Job-Angebote mit Markup (schema.org/JobPosting) zu versehen – und dann dafür keine Reports anzubieten. Auch erzeugen solche Reports eine gewisse Sog-Wirkung, da sich Unternehmen dann fragen, ob sie diese Funktionen bereits nutzen oder das tun sollten.

Fazit

Die neue Google Search Console erfordert definitiv eine Umgewöhnung. Dieses Update ist nicht einfach nur mit den vorherigen Updates vergleichbar, bei denen der Name geändert wurde oder sich Menü-Funktionen verschoben haben. Derzeit wird man allerdings beide Versionen parallel nutzen müssen, da die neue Search Console nur über einen Teil der Funktionen verfügt. Es bleibt also spannend, den weiteren Verlauf zu verfolgen, um so vielleicht noch weitere, ganz neue Funktionen in Aktion zu sehen.

Dieser Beitrag ist in Ausgabe #71 des Magazins für SEO, SEA und E-Commerce „suchradar“erschienen. Die gesamte Ausgabe #71 des suchradars mit dem Fokusthema „Conversion-Rate-Optimierung: Tipps und Strategien für umsatzstarke Websites“ kann unter www.suchradar.de kostenlos als PDF-Version heruntergeladen werden!

Old School Marketing: Mit Print-Mailings Neukunden gewinnen

Old School Marketing: Mit Print-Mailings Neukunden gewinnen Kleine Reichweite, große Wirkung: Mit Mikro-Influencer-Marketing zum Werbeerfolg

Kleine Reichweite, große Wirkung: Mit Mikro-Influencer-Marketing zum Werbeerfolg Newslettermarketing: Branchen-Benchmark zur Orientierung

Newslettermarketing: Branchen-Benchmark zur Orientierung Zahlen prüfen lohnt sich – detailliertes Controlling führt leicht zu mehr Rendite

Zahlen prüfen lohnt sich – detailliertes Controlling führt leicht zu mehr Rendite